-

Applications open

-

Applications close

Schedule

Problemfelt

Systemer baseret på kunstig intelligens (AI) tager i stigende grad beslutninger, som før blev taget af mennesker, eller de foreslår beslutninger, som derefter indgår i menneskers beslutningsprocesser. Et eksempel på det første er medarbejdere der er blevet fyret af algoritmer (link). Et eksempel på det andet er AI der støtter lægers diagnosticering af hudkræft (link).

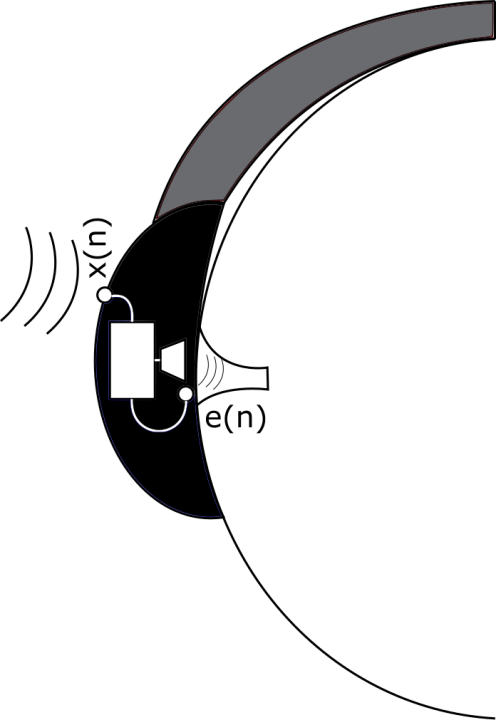

I begge tilfælde er der behov for at AI ikke kun foreslår en beslutning, men også er i stand til at begrunde den. I regelbaserede AI-systemer kunne begrundelserne bestå i at vise hvilken regel, eller hvilken kæde af regler, der førte til beslutningen. Sådanne AI-systemer er imidlertid blevet afløst af AI-systemer baseret på machine learning og deep learning. I disse systemer er der ikke eksplicit formulerede regler; systemerne finder i stedet mønstre på basis af store mængder træningsdata. Det er ikke oplagt hvordan disse systemer skal give en meningsfuld begrundelse for deres anbefalinger/beslutninger. Der er opstået et helt forskningsfelt omkring dette behov: explainable AI (XAI). Udover at det er teknisk svært at forklare hvordan disse anbefalinger/beslutninger bliver til, er der også en kognitiv/filosofisk udfordring: Hvad forstår vi som mennesker ved en god forklaring? En oversigtsartikel over svar på dette spørgsmål er Millers ’Explanation in artificial intelligence: Insights from the social sciences’ (link).

Problemformulering eller arbejdsspørgsmål

- Hvad forstår vi som mennesker ved en god forklaring?

- Hvordan kan moderne AI-systemer baseret på dyb læring balancere teknisk kompleksitet med behovet for forståelige begrundelser? En udforskning af metoder og udfordringer inden for Explainable AI (XAI)

- Brugen af kognitive og psykologiske principper i udviklingen af forklarbar AI: Hvordan kan viden om menneskelig tænkning og beslutningsprocesser informere designet af AI-systemer, der kan forklare deres egne beslutninger?

Metodiske tilgange:

- Et håndterligt projekt om XAI har brug for en case, der konkretiserer problemstillingen og for eksempel gør det muligt at interviewe informanter om hvad de i den konkrete sammenhæng forstår ved en god forklaring.

I kan måske finde en case i KMDs udvalg af AI-løsninger (link). KMD er selv opmærksomme på, at AI skal kunne forklare sig (link).

STS perspektiver:

- Actor-Network Theory (ANT)

- Ethnography of Technology

- Posthumanism

Applications are closed.

Open For

-

Students

Special requirements

HUMTEK 3. semster 2023

Offerings

-

Mentorship

Contact person

University staff, Roskilde University (R...